Der EU AI Act macht Schluss mit dem bisher unregulierten Einsatz von KI – auch bei Tools wie Microsoft Copilot oder eigenen KI-Agenten. Seit August 2024 ist klar: Wer KI im Unternehmen nutzt, braucht bis spätestens 2026 definierte Rollen, dokumentierte Prozesse und ein nachvollziehbares Logging.

Was ist der AI Act?

Der EU AI Act ist die erste umfassende KI-Verordnung weltweit und seit August 2024 in Kraft.

Der Kern des AI Acts ist ein risikobasierter Ansatz: KI-Systeme werden nach ihrem Einsatzgebiet und potenziellen Auswirkungen in verschiedene Risikoklassen eingestuft – von „minimal“ bis „unzulässig“. Je höher das Risiko, desto strenger die Anforderungen: von einfacher Kennzeichnung über Dokumentations- und Kontrollpflichten bis zu Verboten, etwa bei Social Scoring oder manipulativen Systemen.

Damit wird klar: KI betrifft nicht nur IT, sondern HR, Fachbereiche, Datenschutz und Legal gleichermaßen. Inventarlisten, verantwortliche Rollen, Risiko-Bewertungen und nachvollziehbare Entscheidungen sind kein Optional mehr, sondern Pflicht.

Was gilt ab wann?

Unternehmen setzen heute bereits Copilot, ChatGPT oder eigene KI-Agenten ein – meist ohne Inventar, Risiko-Klassifikation oder dokumentierte Verantwortlichkeiten. Noch ist das kein Problem, aber die Übergangsfrist endet: Ab August 2026 gelten die meisten Pflichten für KI-Systeme mit höherem Risiko. Wer bis dahin keine Governance-Strukturen etabliert hat, riskiert Bußgelder und Nutzungsverbote.

Kurzüberblick der wichtigsten Meilensteine:

| Zeitpunkt | Was gilt? |

|---|---|

| Seit Februar 2025 | Verbot unzulässiger KI-Systeme (z.B. Social Scoring, manipulative Systeme) und Pflicht zur grundlegenden KI-Kompetenz (AI Literacy). |

| Bis August 2025 | Anforderungen für General-Purpose-AI-Modelle (z.B. GPT, Gemini) – Transparenz, Dokumentation, Modellkarten. |

| Bis August 2026 | Hauptdeadline: Unternehmen müssen KI-Inventar, Risiko-Klassifikation, Policies, Rollen (RACI), Zulassungsprozesse, Logging und Monitoring umgesetzt haben – besonders für High-Risk-Anwendungen. |

| Ab August 2027 | Zusätzliche Nachweispflichten u.a. für normierte Hochrisiko-Systeme wie Medizinprodukte, Maschinen, Aufzüge etc. |

Die Zeit bis 08/2026 ist keine Beobachtungsphase, sondern eine Umsetzungsphase. Jetzt müssen Inventarlisten aufgebaut, High-Risk-Anwendungen identifiziert, Verantwortlichkeiten definiert und erste Policies getestet werden. Wer wartet, verliert wertvolle Monate und steht 2026 mit hektischen Compliance-Projekten da.

Policies & Prozesse – was bis 2026 dokumentiert sein muss

Damit Copilot, GPT-basierte Assistenten oder eigene KI-Agenten ab 2026 rechtskonform betrieben werden können, reicht es nicht, einzelne Use Cases freizugeben. Unternehmen brauchen ein dokumentiertes Policy-Set und klare Prozesse – schlank, aber verbindlich. Ziel ist ein einheitlicher Rahmen: Wer entscheidet über neue KI-Anwendungen, welche Daten dürfen genutzt werden und wie wird deren Einsatz nachvollziehbar dokumentiert?

Was gehört mindestens in das Policy-Set?

Diese Policies funktionieren nur mit klaren Prozessen dahinter:

Rollen nach RACI – wer trägt welche Verantwortung?

Damit KI-Systeme wie Copilot oder eigene Agenten verantwortungsvoll betrieben werden können, braucht es mehr als Technik – es braucht klare Zuständigkeiten. Der AI Act fordert keine Jobtitel, aber nachvollziehbare Verantwortung. Genau dafür eignet sich eine RACI-Matrix: Wer ist verantwortlich (Responsible), wer entscheidet (Accountable), wer wird eingebunden (Consulted) und wer wird informiert (Informed)?

Typische Rollen im KI-Governance-Modell:

| Rolle | Aufgaben im KI-Einsatz |

|---|---|

| Owner / Fachbereich | Meldet Use Cases, dokumentiert Zweck & Nutzen, verantwortet Ergebnisse. |

| IT / Plattformbetrieb | Technische Einrichtung (z.B. Copilot, Azure OpenAI), Zugriffskontrollen, Integration & Betrieb. |

| Risk / Compliance | Bewertet Risiko, definiert Kontrollmaßnahmen, dokumentiert Risk-Acceptance. |

| Legal / Datenschutz | Prüft rechtliche Rahmenbedingungen, Lizenzen, Datenschutz-Folgenabschätzung. |

| Informationssicherheit | Bewertet Datenzugriffe, Modell-Sicherheit, Schutz vor Missbrauch. |

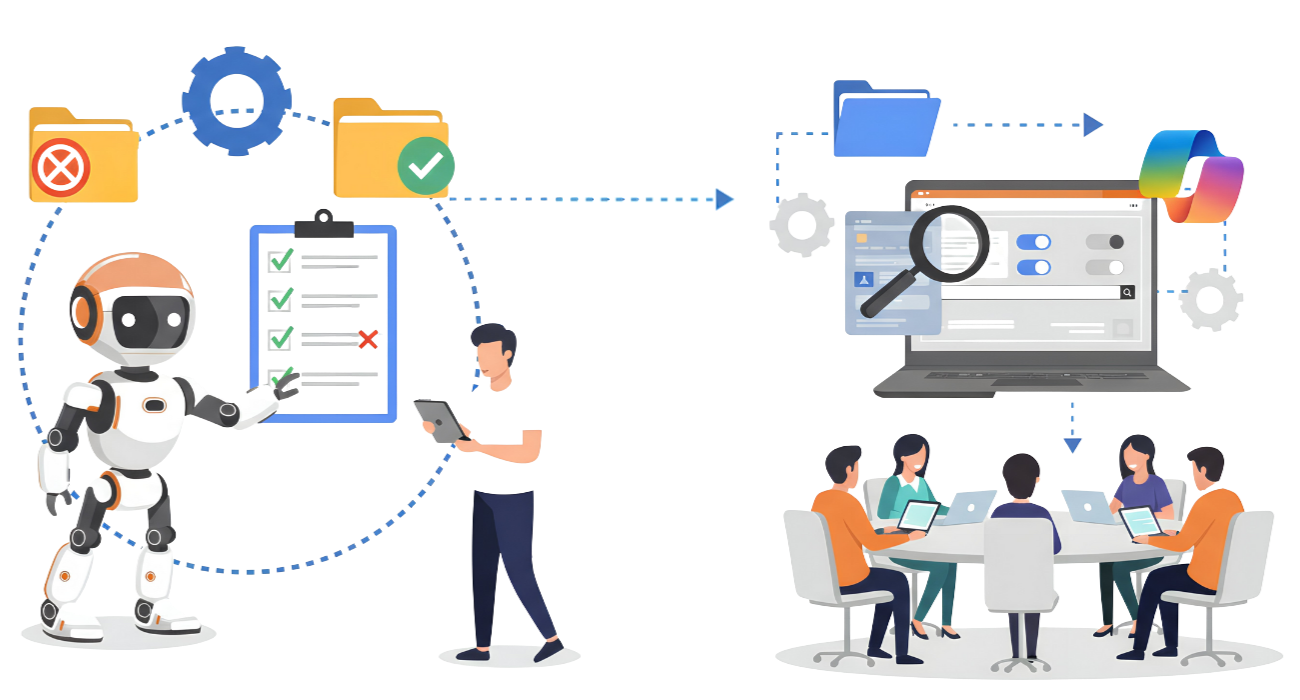

Zulassungsprozess – von der Idee bis zur Freigabe

Um KI-Anwendungen wie Copilot oder eigene Agenten ab 2026 regelkonform betrieben werden können, braucht es einen verbindlichen Freigabeprozess. Ziel ist nicht Bürokratie, sondern Transparenz: Welche KI wird wo eingesetzt, mit welchen Daten, durch wen verantwortet und mit welchem Risiko?

Schritt 1: Use-Case-Steckbrief einreichen

Jeder neue KI-Einsatz wird mit einem kurzen, standardisierten Formular angemeldet. Typische Inhalte:

- Zweck & Nutzen des Use Cases

- Datenquellen und Zugriffsrechte

- Betroffene Nutzer oder Kundengruppen

- Verantwortliche Person im Fachbereich (Owner)

- Technische Umsetzung (z.B. Copilot, Azure OpenAI, internes Modell)

Schritt 2: Risiko-Check nach AI Act

Nach dem Steckbrief erfolgt die Einordnung des Use Cases in die AI-Act-Risikokategorien:

- Niedriges Risiko: z.B. interne Assistenten ohne Personenbezug

- Transparenzpflichtig: z.B. Chatbots, KI-generierte Inhalte

- Hochrisiko: z.B. KI in HR-Prozessen, kritischer Infrastruktur, biometrische Systeme

Je nach Einstufung werden passende Anforderungen ausgelöst, z.B. Dokumentationspflicht, menschliche Aufsicht, Datenqualitäts-Nachweise oder Eintrag in die EU-Datenbank.

Schritt 3: Freigabe & Maßnahmenplan

IT, Datenschutz, Legal und ggf. Risk/Compliance prüfen den Use Case. Erst nach Freigabe darf er produktiv genutzt werden. Wenn Risiken bestehen, aber akzeptabel sind, wird die Entscheidung dokumentiert (Risk Acceptance). Fehlende Kontrollen werden als Maßnahmen mit Frist festgehalten.

Schritt 4: Betrieb & Nachweisführung

Nach Freigabe müssen Logging, Monitoring und Aktualisierung des Steckbriefs sichergestellt sein. Änderungen am Use Case (neue Daten, neue Funktionen) lösen eine erneute Prüfung aus.

Praxisbeispiel – Ein Agent mit klaren Leitplanken

Wie sieht regelkonformer KI-Einsatz konkret aus? Nehmen wir einen internen Agenten, der Mitarbeitenden Fragen zu Produkten, Prozessen oder Richtlinien beantwortet. Der Unterschied zu „einfach einschalten“: Der Agent arbeitet nur mit freigegebenen Informationen, wird geprüft, dokumentiert und begleitet betrieben.

Datenzugriffe – nur freigegebene Quellen statt „alles offen“

Der Agent erhält keinen Vollzugriff auf das Firmennetzwerk, sondern nur auf klar definierte Datenquellen – zum Beispiel Produktdokumentation, Handbücher und interne FAQs. Systeme mit sensiblen Informationen wie HR-Daten, Verträge oder personenbezogenen Kundendaten sind ausgeschlossen oder nur über Rollen mit stark eingeschränkten Berechtigungen zugänglich. Technisch erfolgt die Steuerung über Rechte in M365, Azure AD oder vergleichbaren Systemen. So bleibt nachvollziehbar, auf welche Inhalte der Agent zugreift.

Approval & Tests – bevor der Agent live geht

Bevor der Agent live geht, wird der Use Case über einen Steckbrief angemeldet: Zweck, Datenquellen, verantwortlicher Fachbereich, Risiko-Einschätzung. IT, Datenschutz und ggf. Compliance prüfen diesen Antrag. Danach folgt eine Testphase in einer sicheren Umgebung. Hier wird untersucht, ob der Agent falsche Inhalte erzeugt, vertrauliche Informationen preisgibt oder sich unvorhersehbar verhält. Erst wenn Ergebnisse stabil sind und Leitplanken greifen, erfolgt die Freigabe für den produktiven Einsatz.

Schulung & Change – wie Mitarbeitende sicher mit KI arbeiten

Auch der beste Agent funktioniert nur, wenn Menschen korrekt damit umgehen. Deshalb werden Nutzer geschult: Welche Prompts funktionieren? Welche Daten nutzt der Agent? Wann muss ich Ergebnisse prüfen und freigeben? Dazu gehört auch ein klarer Hinweis, dass KI unterstützt, aber keine Entscheidungen ersetzt. Parallel wird ein Feedback-Kanal eingerichtet, über den Fehler, neue Anforderungen oder Verbesserungsvorschläge gemeldet werden können. So bleibt der Agent kein Einmal-Projekt, sondern ein kontrollierter, lernender Bestandteil der Organisation.

Bereit, Copilot & KI-Agenten sicher in den Betrieb zu bringen?

Viele Unternehmen stehen jetzt vor derselben Aufgabe: KI nutzen, aber strukturiert, kontrolliert und AI-Act-konform. Wir unterstützen Sie genau dort, wo intern Ressourcen oder Erfahrung fehlen. Ob Governance-Konzept, Risikoanalyse, Policy-Entwicklung oder Pilotprojekt mit Copilot & Agenten – wir gestalten den Prozess gemeinsam mit Ihren Teams. So wird KI vom Experiment zum festen Bestandteil Ihres Betriebs.